صفر تا صد سئو | درس پنجم: ساختار موتورهای جستجو زیر ذره بین

همانطور که در درس های قبل توضیح دادیم، سئو به منظور ایجاد تجربه کاربری بهتر برای مخاطبان و در نهایت افزایش رتبه و بالا آوردن سایت در نتایج موتورهای جستجو انجام می شود. بنابراین برای تبدیل شدن به یک متخصص سئو هیچ چیز به اندازه شناخت نحوه کار کاربران با موتورهای جستجو و نحوه رتبه بندی سایت ها توسط ربات ها اهمیت ندارد.

در این آموزش یعنی پنجمین درس از مجموعه آموزشی صفر تا صد سئو به شناخت قسمت های مختلف موتورهای جستجو و بررسی دقیق و جزئی عملکرد این ربات ها می پردازیم. با ما همراه باشید...

عملکرد یک موتور جستجو چگونه است؟

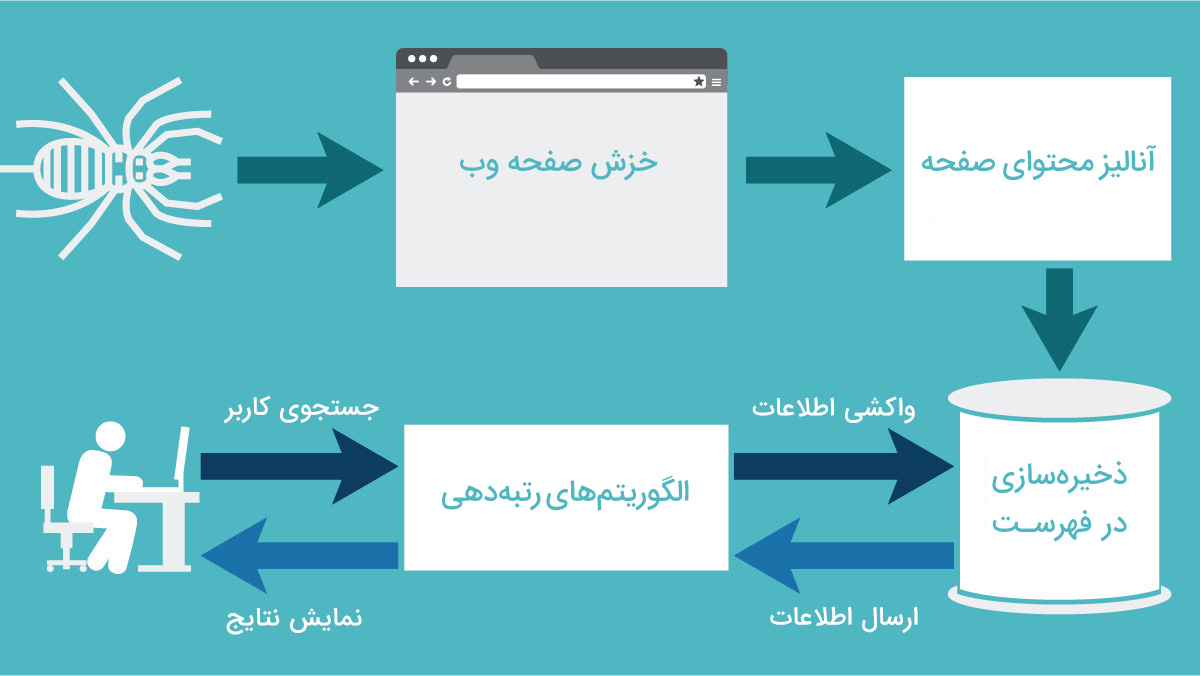

اگر به تصویر بالا دقت کنید متوجه می شوید که موتورهای جستجو مانند گوگل برای تحلیل محتوای وب سایت ها و نمایش آن به کاربران باید سه مرحله اصلی را طی کنند:

- مرحله اول که Crawling نام دارد به معنی خزش در وب سایت ها به منظور کشف محتواهای جدید ایجاد شده توسط وبمسترها می باشد.

- مرحله دوم که Index نامیده می شود برای ذخیره محتوای وب سایت ها به صورت یک نسخه فشرده در بانک اطلاعاتی گوگل انجام می شود.

- مرحله سوم یعنی Results برای نمایش لیست وب سایت ها با محتواهای مرتبط هنگام جستجوی کاربران انجام می شود.

Crawling یا خزش در موتورهای جستجو به چه معناست؟

گوگل برای اینکه محتواهای تازه تولید شده در دنیای وب را شناسایی کند، ربات هایی را طراحی کرده است که Crawler (به معنی خزنده) نامیده می شوند. این ربات ها رفتاری همانند بازدیدکنندگان وب سایت دارند و هنگامی که وارد وب سایتی می شوند، محتوای کامل آن را که شامل عناوین، متن ها، تصاویر، لینک ها و ... می شود، بررسی می کنند.

یکی از ویژگی های مهم این خزنده ها این است که هنگامی که در یک وب سایت در حال کاوش محتوا هستند و به لینک صفحه تازه ای برخورد می کنند، وارد آن صفحه می شوند و محتوای کامل آن صفحه را مورد بررسی قرار می دهند. حال باید اهمیت بک لینک های معتر در سئو را فهمیده باشید.

ممکن است از خود بپرسید:

خرنده های گوگل چه مدت یکبار محتوای سایت را مجددا کاوش می کنند؟

در پاسخ باید بگوییم که تعداد دفعات خزش در وبسایت ها در محدوده های زمانی بستگی به وبسایت مورد نظر دارد و از در هر سایت نسبت به سایت دیگر متفاوت است. گوگل به مرور زمان میانگین تعداد آپدیت صفحات سایت شما در روز را شناسایی کرده و سرعت خزش در سایت شما متناسب با آن تنظیم می کند. برای مثال سایت هایی که هر روز با چند محتوای تازه آپدیت می شوند و کاربران زیادی نیز مرتبا از این محتوا ها بازدید می کنند، نسبت به سایت هایی که دیر به دیر آپدیت شده و بازدید مناسبی ندارند، سریع تر Crawl یا خزش می شوند.

البته در ابزار Google Webmaster Tools می توان این سرعت را برای وب سایت خود به صورت دستی تغییر داد اما اینکار تنها به افراد متخصص و با تجربه پیشنهاد می شود. اگر تازه کار هستید دست نگه دارید و درس های بعدی مجموعه آموزشی صفر تا صد سئو در روکسوپلاس را مطالعه کنید. در درس های بعد به آموزش کار با ابزارهای سئو مانند گوگل وبمستر تولز و تغییرات دستی در تنظیمات Crawling خواهیم پرداخت.

موتور های جستجو چگونه محتوای سایت ها را Index می کنند؟

پس از آنکه کار خزنده ها در بررسی محتواهای جدید سایت به پایان رسید، نوبت به ایندکس سایت می رسد.

همانطور که در درس های قبل مثال زدیم، گوگل همانند کتابدار یک کتابخانه بسیار وسیع است که تمامی کتاب های دنیا در آن نگهداری می شوند. این موتور جستجو همانند سایر موتور های جستجو از بانک های اطلاعاتی بسیار وسیع تشکیل شده است که Crawlerهای اختصاصی آن، محتواهای ایجاد شده در سایت های مختلف را به صورت نسخه های فشرده در آن ها ذخیره می کنند. به این کار ایندکس گفته می شود.

اگر صفحه ای ایندکس نشود هیچگاه در نتایج جستجوی کاربران نمایش داده نخواهد شد. بنابراین اولین قدم برای نمایش سایت در نتایج جستجو اطمینان از ایندکس شدن صفحات سایت توسط موتور های جستجو می باشد.

تهیه لیست نتایج جستجو برای مخاطبان چگونه انجام می شود؟

ذخیره محتوای وب سایت ها بصورت نسخه های فشرده این امکان را فراهم می کند که گوگل هنگام جستجوی کاربران به سرعت لیستی از وب سایت های دارای محتوای مرتبط را ایجاد کرده و به کاربر نمایش دهد. اما اینکه ترتیب این لیست چگونه تنظیم می شود به عوامل مختلفی بستگی دارد. این عوامل همان مواردی هستند که در درس دوم این سری آموزشی توضیح داده شدند.

جمع بندی

در این درس یعنی پنجمین درس از سری آموزشی صفر تا صد سئو عملکرد موتورهای جستجو را بررسی کردیم. در این آموزش آموختید که موتورهای جستجو همانند گوگل چگونه محتواهای جدید منتشر شده در سایت ها را شناسایی کرده، به چه شکل ذخیره و ایندکس می کنند و به هنگام جستجوی کاربران چگونه آنها را لیست می کنند. هرچه وب سایت شما در زمینه های سئوی تکنیکال، سئوی داخل صفحه و سئوی خارجی در وضعیت بهتری قرار داشته باشد، نزد گوگل از اعتبار بیشتری برخوردار بوده و در ابتدای لیست های نتایج جستجو ظاهر خواهد شد.

امیدواریم این آموزش مورد استفاده شما همراهان عزیز روکسو قرار گرفته باشد. در ضمن می توانید در پایین همین صفحه نظرات خود را درباره این سری آموزشی با ما به اشتراک بگذارید. پیروز و سربلند باشید...

در این قسمت، به پرسشهای تخصصی شما دربارهی محتوای مقاله پاسخ داده نمیشود. سوالات خود را اینجا بپرسید.

در این قسمت، به پرسشهای تخصصی شما دربارهی محتوای مقاله پاسخ داده نمیشود. سوالات خود را اینجا بپرسید.